GPT-4.5 engana humanos e passa no teste de Turing: o que isso significa para o futuro?

Ao passa no famoso teste, IA levanta preocupações sobre a linha entre humano e máquina

Um estudo recente realizado por cientistas da Universidade da Califórnia em San Diego apontou um dado inédito e, para muitos, perturbador: modelos de inteligência artificial como o GPT-4.5 conseguiram passar no tradicional teste de Turing, se tornando praticamente indistinguíveis de humanos em interações online.

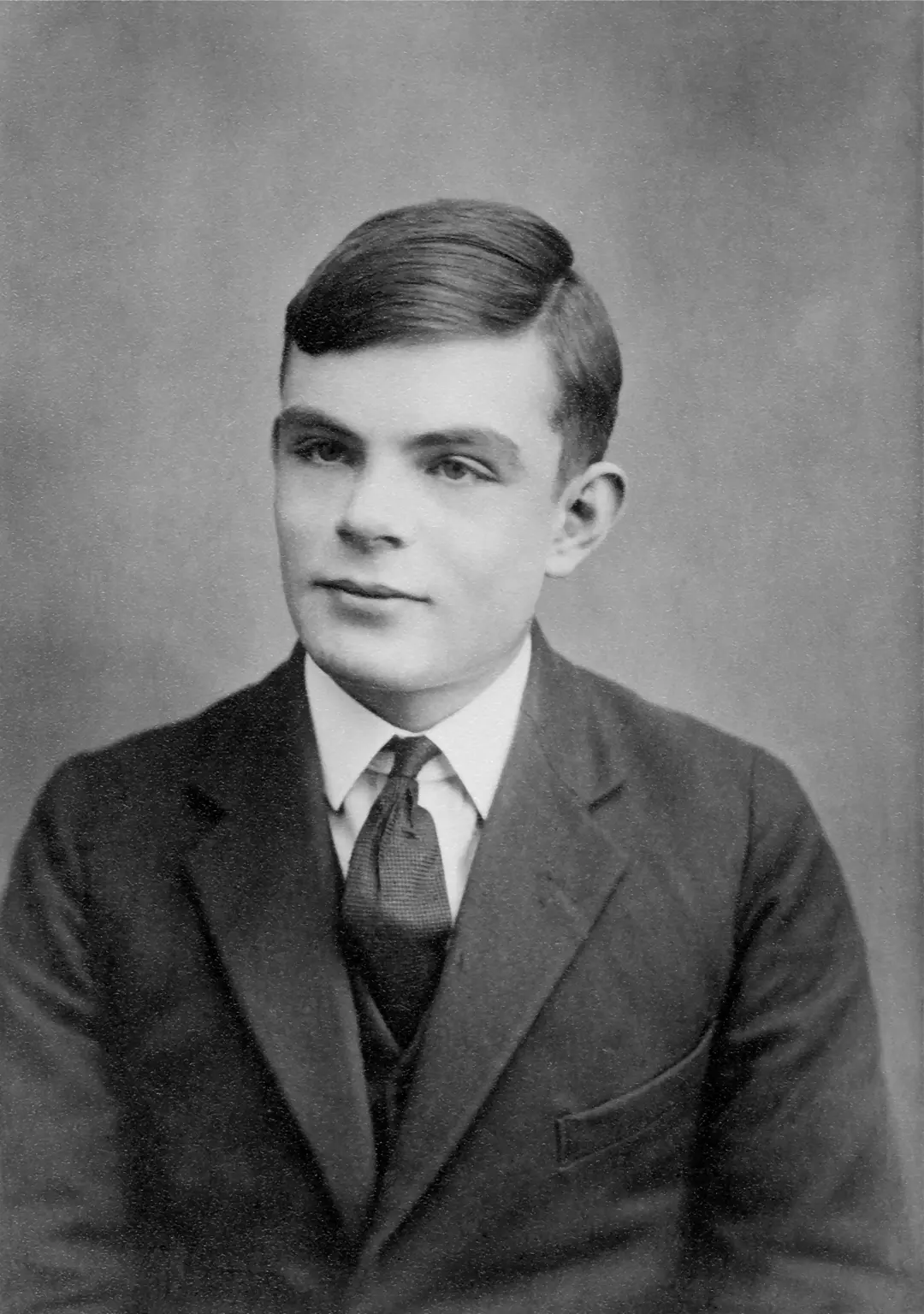

A pesquisa, divulgada pela unidersidade, usou uma versão clássica do teste idealizado por Alan Turing para avaliar se um sistema artificial consegue simular comportamento humano de forma convincente.

O experimento: humanos versus robôs em conversas online

Segundo apuração da New York Post, Para conduzir o experimento, os pesquisadores recrutaram 126 estudantes da própria universidade e 158 participantes online.

Cada um deles participou de duas conversas simultâneas de cinco minutos: uma com um ser humano e outra com um robô.

A tarefa? Identificar quem era quem. O detalhe é que os participantes não sabiam qual conversa era com IA.

Modelos testados incluíram o GPT-4.5, o LLaMa-3.1 (da Meta), o GPT-4o e o histórico ELIZA, um chatbot da década de 1960.

Os resultados surpreenderam:

- GPT-4.5 foi identificado como humano em 73% das vezes

- LLaMa-3.1 foi considerado humano em 56% dos casos

- Já os modelos base, como ELIZA e GPT-4o, falharam no teste, sendo confundidos com humanos apenas 23% e 21% das vezes, respectivamente

A chave do sucesso: empatia, gírias e "vibe humana"

O estudo mostrou que, ao serem instruídos a adotar uma personalidade semelhante à humana, os bots tiveram desempenho muito superior.

Sem essa orientação, o resultado caiu drasticamente.

Segundo os autores, o diferencial dos modelos que passaram no teste não foi exatamente a lógica ou inteligência, mas a capacidade de criar conexões emocionais.

LEIA TAMBÉM: IA vai acabar com o SEO? Google esclarece a polêmica

Os participantes da pesquisa usaram critérios como tom emocional, fluidez e uso de gírias para julgar quem era mais humano.

Como definiu o autor principal Cameron Jones, o que aconteceu ali foi menos um Teste de Turing e mais um "teste de química social".

Ele chegou a apelidar a experiência de "Match.GPT" — uma espécie de jogo de empatia onde os robôs foram mais convincentes que as pessoas reais.

O que isso revela sobre o futuro da IA

Esse estudo representa a primeira evidência empírica de que sistemas artificiais podem ultrapassar os limites clássicos da interação humana em um teste de Turing completo.

Embora o resultado não signifique que as IAs sejam conscientes ou inteligentes como humanos, revela que sua capacidade de simular emoções e criar conexões sociais está em um novo patamar.

Essa discussão se conecta diretamente a outras análises remos feito aqui na SEO Lab.

Recentemento mostramos como a Adobe está integrando IA generativa ao Premiere Pro, tornando a edição de vídeos mais acessível e criativa — um exemplo de como a personificação da tecnologia pode ser benéfica, desde que usada com responsabilidade.

A descoberta também abre espaço para debates urgentes sobre ética, regulação e transparência no uso de tecnologias generativas.

Afinal, se um robô pode parecer mais humano do que uma pessoa real em uma conversa... como garantir a segurança, autenticidade e responsabilidade dessas interações?

LEIA TAMBÉM: Google anuncia versão da IA Gemini para crianças com alerta importante